離れたタブレットからPCを操作してみたく、VNCやウィンドウズのリモート機能を試しましたが、このSplashtop2というソフトが群を抜いてパフォーマンスが高い。

サウンドも普通に転送され、リモートするPCのデスクトップは解像度をそのまま維持、マルチモニタに対応したモニタの切り替え機能もあります。

接続後、設定をsharpからsmoothに変えると、多少文字が滲んだ感じになるが動画やゲームも何とかできそうなフレームで描写される。

タブレットはPC用のマウス・キーボードもサポートしているので、それらを併用すればリモート先のPCをそのまま使っている感じになりますね。

リモートされるPCはStreamerっていう専用ソフトを常駐させるんですが、名前からして画像の連続転送ではなく動画みたいなストリーミング処理したデータを送っているんだろうか?

このソフトに限らずタブレットのリモートアプリは、Googleアカウントで同期すればポートを空けたりせずとも簡単にPCを検出できたりします。

http://www.splashtop.com/ja/splashtop2

http://www.youtube.com/watch?v=80e80QMvIy8

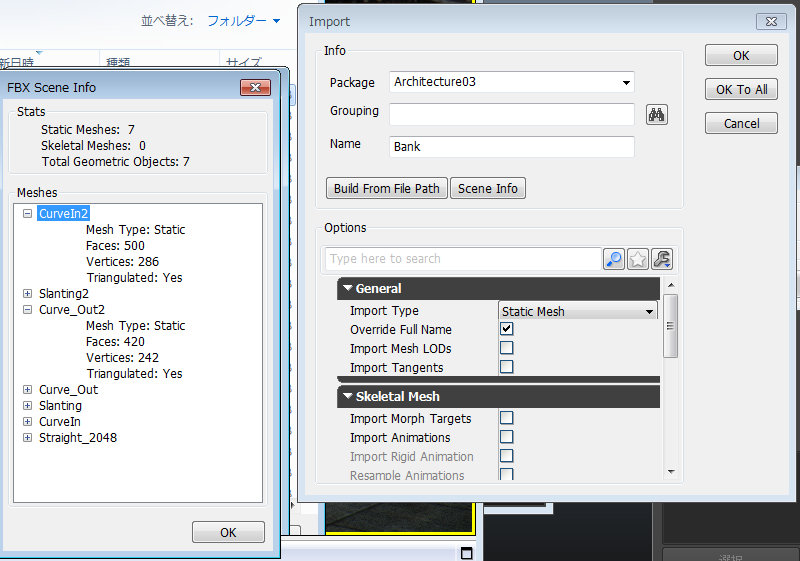

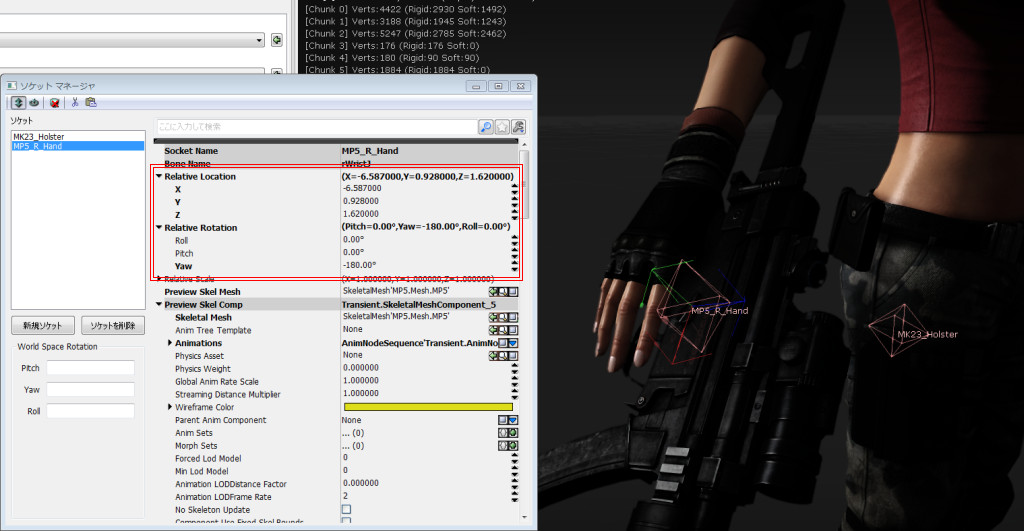

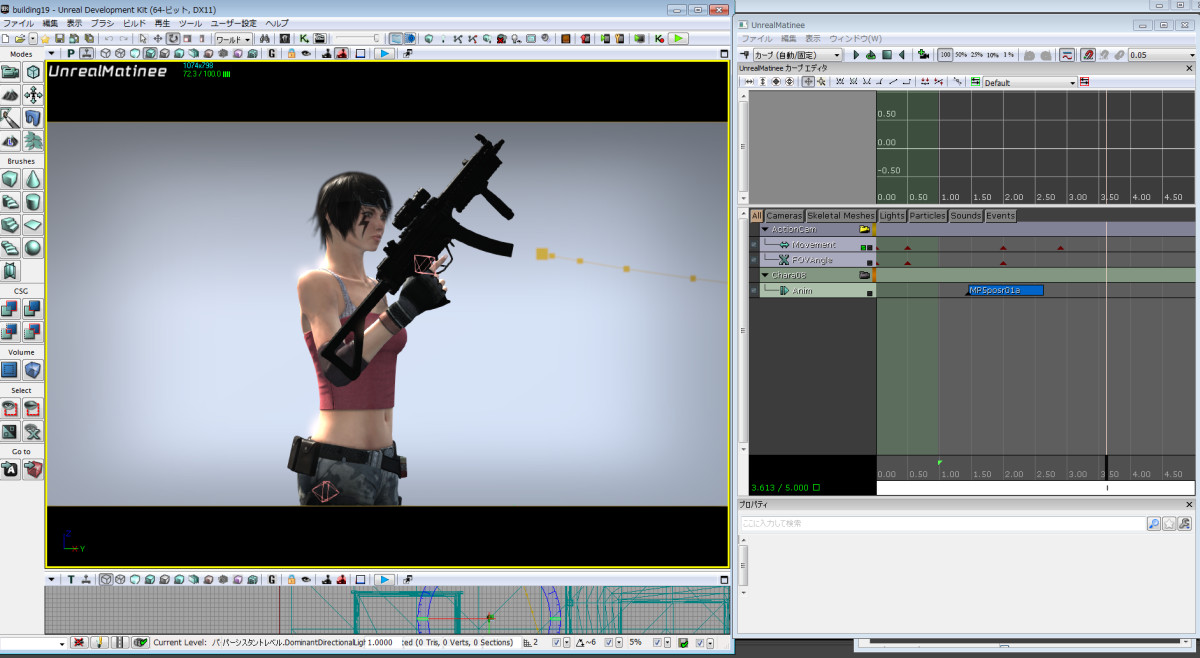

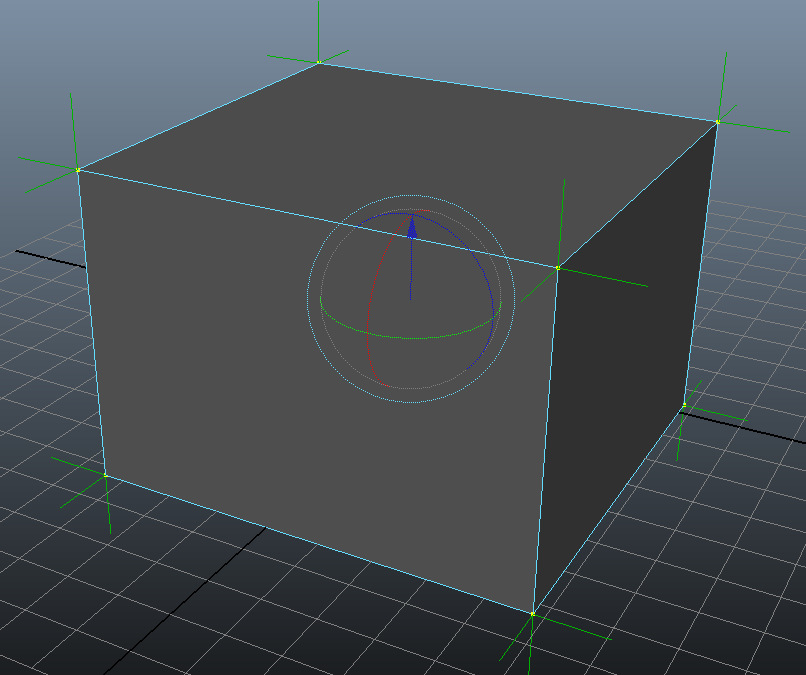

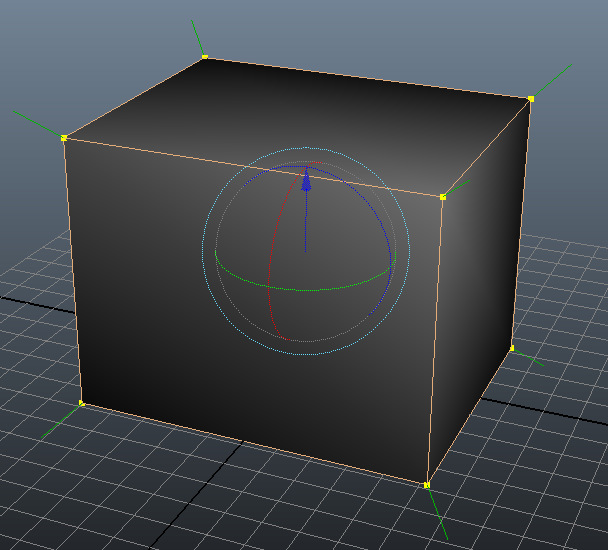

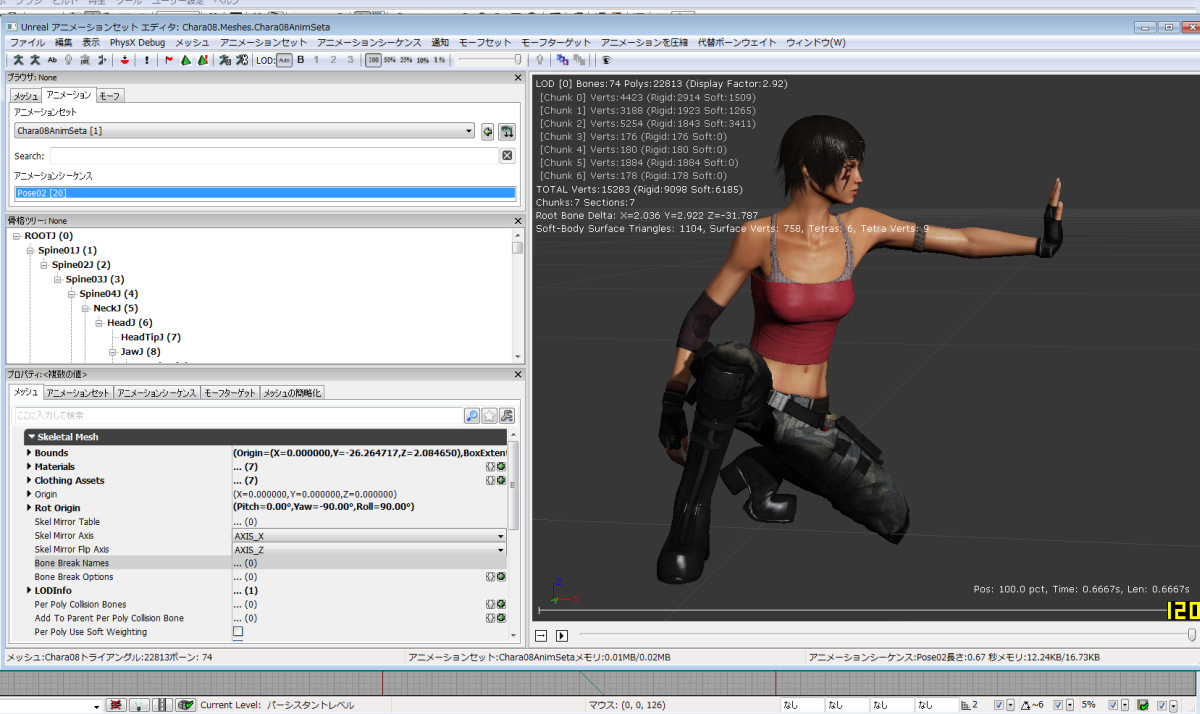

UDKのKismet、特にMatineeを勉強中。

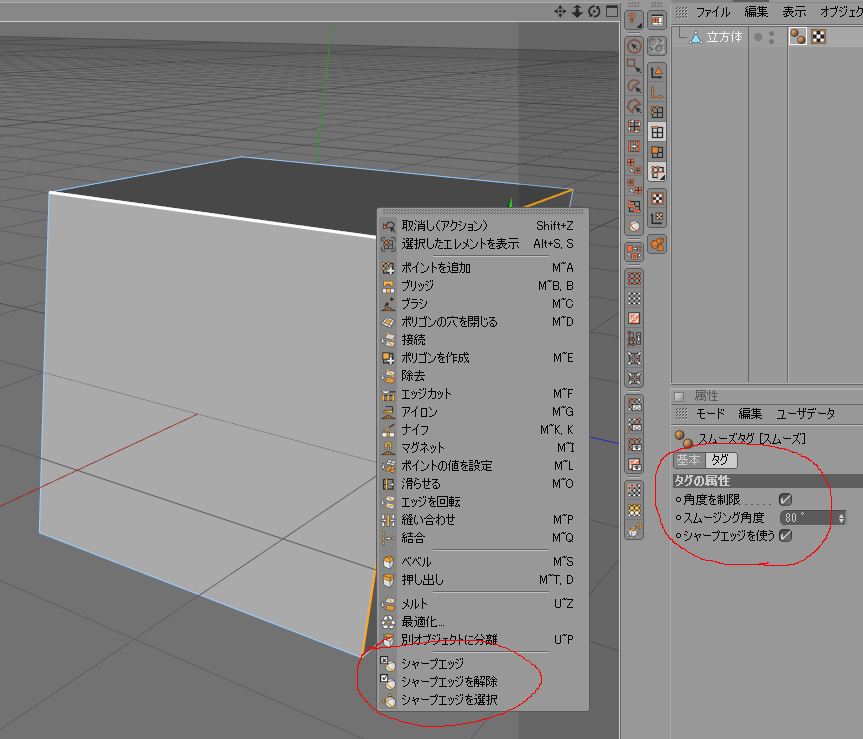

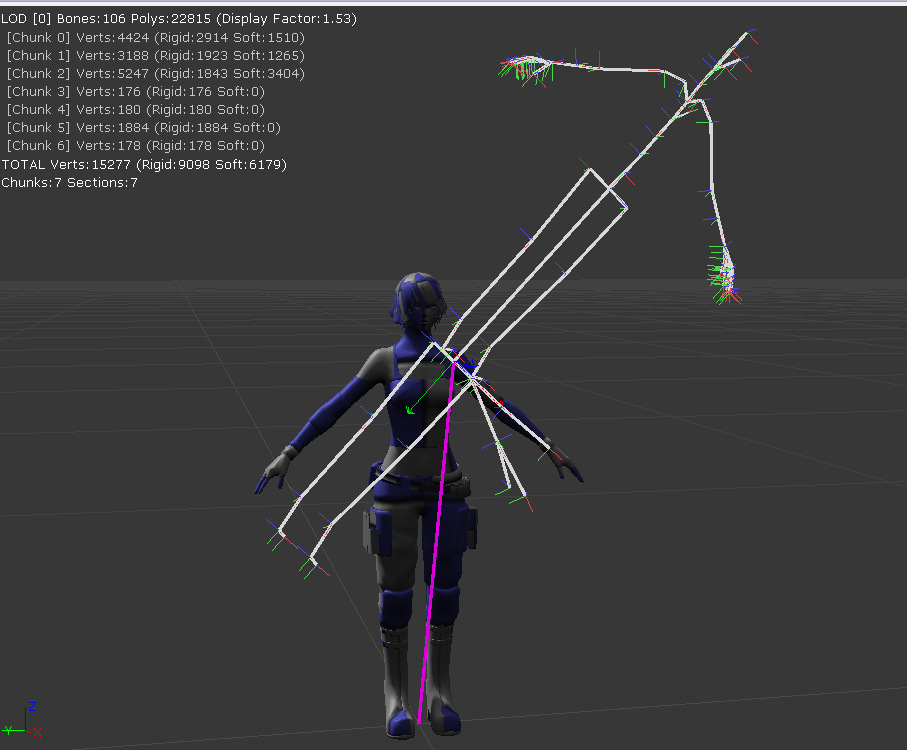

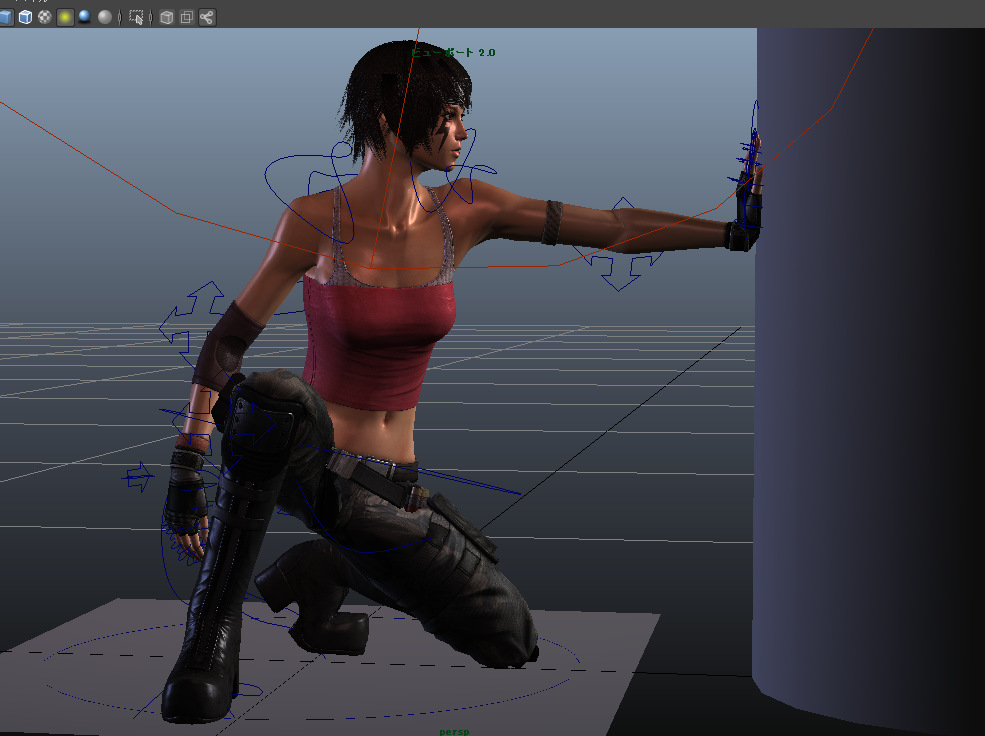

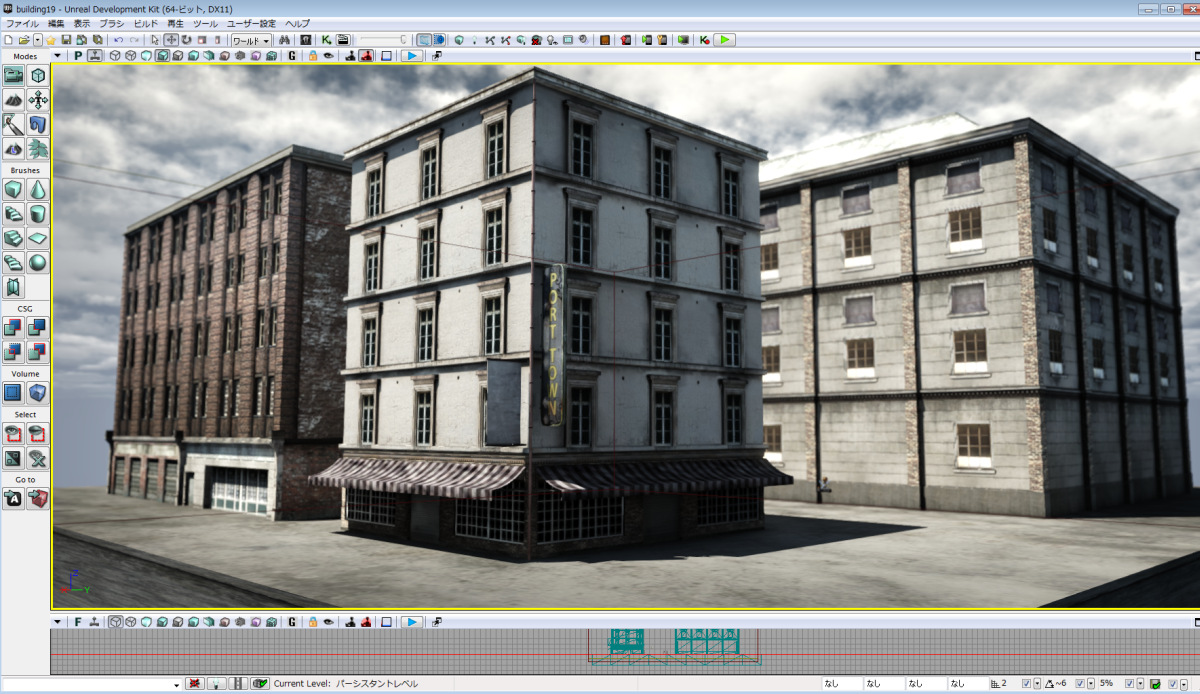

シーンを丸ごとFBXに出せますね。しかもUDKで編集した頂点カラー情報も維持している。DCCツールで丸ごとシーンを構築する場合に便利そう。